Vortrag im Rahmen des Oldenburger Komponisten-Colloquiums am 19.6.2015

Elektronische Musik made in Oldenburg

In Oldenburg bin ich seit 1978 im Rahmen der Apparativen Musikpraxis Schwerpunkt experimentelle Musik und Musikprogrammierung tätig.

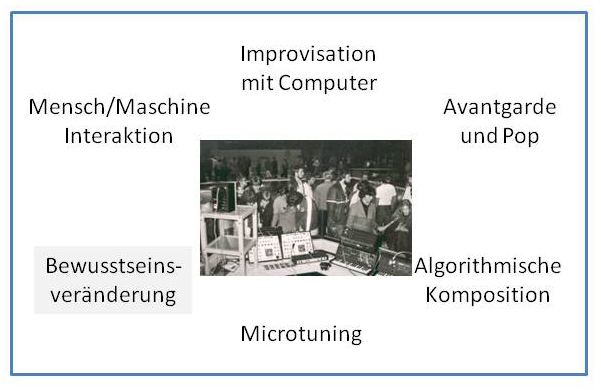

In diesem Zusammenhang entstanden mehrere künstlerisch-wissenschaftliche Forschungsprojekte, die alle der Kategorie "Live Elektronik"

zuzuordnen sind. Forschungsfragen sind: Mensch-Maschine-Interaktion, Improvisation mit Computer, Algorithmisches Komponieren, Microtuning. Das Wesentliche dieser Projekte ist, dass die Produktionen sich im kommerziellen Musikbetrieb bewähren müssen. Keine Laborproduktionen, kein Sponsoring, keine Drittmittel. Beispiel Microtune-Programme für die Firma Geerdes (Berlin), Programmtester für den Lugert-Verlag, Brain & Body mit 39 Auftritten auf Festivals und in Clubs auf, 75 Kompositionsaufträge und 27 Konzerte fürs MIDI-Planetarium, oder zwischen 1998 und 2003 pro Semester eine Rave-Party des TechnoMuseums. Keine Vorführung gleicht der anderen, jedes Event wird neu generiert, ich als "Komponist" schaffe keine Werke sondern Ideen und Materialien für Aktionen und wirke bei der Aufführung mit.

Im heutigen Colloquium versuche ich einen Eindruck von den elektronischen Klängen zu geben, die aus einigen dieser Projekte hervorgegangen sind.

Projekt 1: Becerra-Schmidts "Balistoccata"

Gustavo Becerra-Schmidt hat die "Balistoccata" 1982 als Reaktion auf den Militärputsch 1973 in Chile komponiert und Fred Ritzel gewidmet. Der Putsch hatte aus Becerra-Schmidt einen Exilanten gemacht. Das Stück existiert in 4 Fassungen: (Original-)Fassung 1 für Klavier, Fassung 2 von Becerra-Schmidt für Midiklavier, Fassung 3 (1983) Midiversion elektronisch im Korg MS10 verfremdet von Wolfgang Martin Stroh, Fassung 4 (2010) im Nordlead die Fassung 3 neu bearbeitet und mit Samples gemischt. Im vorliegenden Video hört man zunächst die Original-Version gespielt von Ljuba Markova, anschließend die 1979 entstandene Verfremdung durch den Synthesizer Korg MS 20, und abschließend eine Neubearbeitung mittels des Moduls "Nordlead", bei der die in der Klavierkomposition eingearbeiteten chilenischen Protestlieder explizit als Samples zu hören sind. Die Version für Midiklavier aus dem Jahr 1983 ist insofern ein Novum, als Becerra-Schmidt mittels eines aus Israel importierten Notationsprogramms überhaupt eine midifizierte Version seiner zunächst von Hand gezeichneten Partitur erstellen konnte. Man erinnere sich: Midi wurde im August 1982 "erfunden" bzw. zur internationalen Norm erklärt. Die Midi-Version erlaubte es, die Virtuosität des Stücks nochmals etwas zu steigern. Zwischen Fassung 2 und 4 besteht ein qualitativer Unterschied: Da der Korg MS 20 ja ein rein analoger Synthis ist, wurde in der Fassung 3 die Audioversion des Stücks (die auch von Hand hätte gespielt werden können) analog verarbeitet, d.h. überwiegend durch Filter und Übersteuerungen moduliert. Bei der Fassung 4 wurde der midifizierte Soundmodul "Nordlead" verwendet, sodass jetzt die Mididaten die synthetischen Klänge triggern konnten.

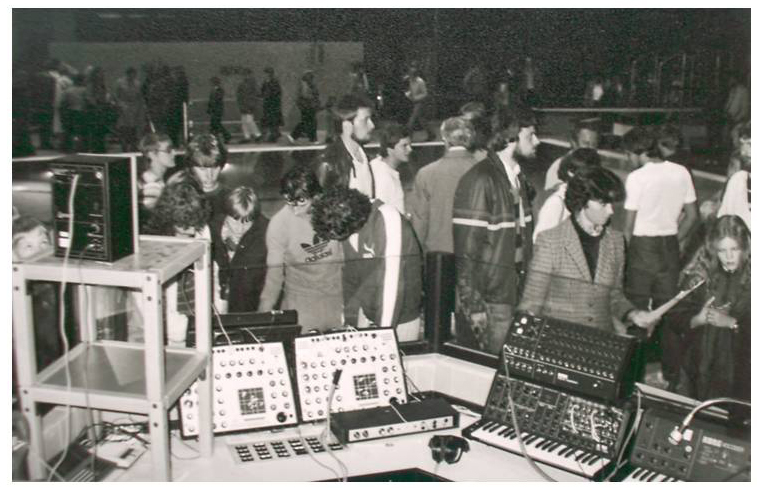

Projekt 2: Wassermusik - Zur Einweihung des Uni-Hallenbades

Im Bad verteilt befinden sich verschiedene "Sensoren", deren Funktonsweise darin besteht, dass die Besucher durch "Bewässerung" derselben einen Kurzschluss auslösen konnten, der wiederum einen elektronischen Klang triggert. Der jeweils ausglöst Klang wurde über einen an einer anderen Stelle im Raum aufgestellten Lautsprecher wiedergegeben. Die Besucher konnten auf einem Blatt, das sich mit "Musikalitätstest" bezeichnete, angeben, welcher "Sensor" welchen Lautsprecher triggert. Diese Aufgabe war deshalb nicht ganz einfach, weil es im Bad relativ laut war und meist mehrere "Sensoren"/Lautsprecher gleichzeitig aktiv waren. Der Test wurde von mir ausgewertet und die Ergebnisse in meinem Buch "Leben Ja. Zur Psychologie musikalischer Tätigkeit" (1984) ausgewertet. Die Aktion wurde als Beweis für die irrationale Testgläubigkeit von Normalbürgern" und die Ideo,ogie des Begriffs "Musikalität"gewertet. In musikalischer Hinsicht jedoch handelte es sich um eine allgemein akzeptierte elektronische und interaktive Rauminstallation. IM Bild sieht man die zum Einsatz gebrachten Synthesizer: 2 SynthiA von EMS (heute mit extremem Kultstatus) und die komplette Korg MS-Serie mit alanogem Synthi, Sequenzer und Vocoder.

Projekt 3: Schönberg für Kids

Eine 1986 für den Schulgebrauch hergestellte Version einer Passage aus

Arnold Schönbergs Klaverstücken Opus 25. Die komplette Klavierpassage

wurde zunächst in Basic-Daten des Commodore kodiert. Sodann wurden diese

Datei mittels eines Basic-Programms "aleatorisch" wiedergegeben, d.h. über

die internen Sounds des C 64 sowie einen kleinen Soundmodul für

Percussinsklänge abgespielt.

Im Video hört und sieht man zunächst das Original für Klavier und

anschließend die Bearbeitung. Der Commodore ist eine tragbare Version des

C 64, genannt SX 64 mit kleinem Bildschirm, daneben dem Diskettenlaufwerk,

rechts daneben der Soundmodul und vorne die externe Tastatur.

Ich habe in den Anfangsjahören der Computermusik 1986-87 für die "Grünen

Hefte" des Lugert-Verlages kontinuierlich über die pädagogischen

Potentiale von Computern und Musikprogrammierung publiziert. Nach

Abschluss dieser Publikationsreihe hatte der Atari ST den Commodore als

Musikcomputer abgelöst.

Das letzte Bild des Videos zeigt einen Atari-Programmierworkshop, den ich

im Oldenburger Computermuseum OCM im Jahr abgehalten habe.

Projekt 4:Algorithmisches Komponieren

In den Hochzeiten des Atari ST als Musikcomputer habe ich viel mit den musikalischen und gestaltpsychologischen Effekten von Algorithmen experimentiert. Im Gegensatz zur überzüchtenen "Formalzed Music" eines Iannis Xenakis waren meine Algorithmen stets einfach, musikalisch durchsichtig und von Laien (vor allem auch Schüler/innen) navh zu vollziehen. In zwei Lehrbüchern "MIDI-Experimente und Algorithmisches Komponieren" (1990 und 1991) habe ich viele schultaugliche Experimente vorgestellt - und auch über Praxiserfahrungen publiziert.

Dies erst Video zeigt an einem harmlosen Beispiel die musikalisch Potenz von "algorithmischem Komponieren". Zum Tragen kommt ein simpler Zufallsalgorithmus, der pro Takt (mit je 8 Achteln) einen von 6 Percussionsklängen zufallsbedingt verändert. Auf den Zentral-Beats (1. und 5. Achtel) bleiben BD und SN unverändert. Faktisch werden die GM-Zahlen der auf jeder Soundcard enthaltene Percussionsklänge bei jedem Takt zufallsbedingt um eins erhöht. Das Ergebnis dieses denkbar einfachen. Dennoch bietet dieser Algorithmus einen interessanten minimalistischen und gestaltpsychologisch wirksamen Effekt. Im Video wird die Realisierung dieser Idee aus dem Jahr 1990 auf einem Atari ST gezeigt. Weitere Anwendungen algorithmischen Komponierens: im nächsten Video der Playlist sowie in der Dokumentation eines Konzertes "Fractal Music" auf https://www.musik-for.uni-oldenburg.de/fractalmusic/.

Das folgende Video zeigt ein musikalisch ausgearbeitetes Beispiel algorithmischen Komponierens, bei dem Das Duo "Brain & Body" (Peter Bayreuther und Wolfgang Martin Stroh) einen algorithmischen Blues auf den Marston nach Hans Cousto spielt.

Dem Algorithmus liegt die rekursive Formel X(n+1) = A* X(n) + B modulo 60 zugrunde. Das bedeutet, dass der jeweils nächste Ton aus dem vorhergehenden nach einer festen Regel errechnet wird. Nach jeweils 8 Takten (d.h. 64 Tönen) wird im vorliegenden Beispiel der Wert von A um 0,01 verändert. Dies sieht man im Demo-Teil am Anfang des Videos. Die Werte von X müssen auf ganze Zahlen herunter gebrochen und, falls sie den Wert von 60 überschreiten, "herunter transponiert" werden, damit sie in Midizahlen und damit Tonhöhen umgesetzt werden können. So kommt es, dass nach einer endlichen Anzahl N von Berechnungen ein X-Wert auftaucht, der schon einmal dran war. Sobald dies geschieht, wiederholt sich das Spiel. So entstehen Wiederholungen von Pattern recht unterschiedlicher Länge. Erstaunlich ist, dass kleine Veränderungen des Wertes von A qualitative Sprünge dieser "Motivstruktur" bewirken. Und dies ist der musikalische Reiz des vorliegenden Musikstücks. Jede 8-Takt-Einheit zerfällt in einen Teil, bei dem sich nichts wiederholt, und einen Teil, in dem die Wiederholungen stattfinden. Diese beiden Teile sind im "Mars-Blues" durch unterschiedliche Instrumentation hervorgehoben. Der Geiger und Sänger Peter Bayreuther improvisiert über dies Schema. Da das ganze algorithmische Spiel von einem ersten Ton X(1) ausgeht, ist dies der Grundton. Dieser Grundton ändert sich im Verlauf des Stücks gemäß dem Bluesschema. Zudem wird im vorliegenden Beispiel nicht eine temperierte Stimmung und nicht ein Kammerton 440Hz sondern eine Obertonstimmung auf dem nach Hans Cousto errechneten Planetenton des Mars verwendet.

Musikalisches Ziel dieser Komposition war also, viel (esoterischen)

Hintersinn mit einem hörpsychologisch erstaunlichen Algorithmus so zu

verbinden, dass eine einfach hörbare und vom Publikum akzeptierbare Musik

- nämlich ein "Blues" - entsteht, bei der strengste Mathematik,

hörpsychologischer Zufall und inspirierende Improvisation zusammen wirken.

Siehe auch

https://www.musik-for.uni-oldenburg.de/fractalmusic

Projekt 5: Computerimprovisation

In der zweiten Hälfte der 1980er Jahre habe ich unter verschiedenen äußeren Bedingungen die Frage untersucht "Kann und soll man auf Computern improvisieren?" (In der Zs. KEYS 5/1990 und 1/1991 gibt es dazu Artikel.)

Am 6.2.1986 gab das Trio "New Fusion" (Peter Bayreuther, Wolfgang Meyberg, Wolfgang Martin Stroh) im Kammermusiksaal der Uni Oldenburg ein Konzert , bei dem der Commodore 64 in Verbindung mit diversen elektronischen Geräten improvisatorisch eingesetzt wurde. Im Video, dessen Soundtrack Ausschnitte aus diesem Konzert enthält, wird das "Programmblatt" gezeigt, das die Kompositionsweise der live-elektronischen Improvisation erläutert. Bei 0:12 min:sec sieht man das gesamte Equipment: Neben besagtem C 64, der tüchtig vorprogrammiert war, wurden ein Synthi MS 20 von Korg, zwei Synthis Juno 6 (rein analog) und Juno 106 (digital-analog) von Roland, ein Rhythmuscomputer, ein einfacher Sequenzer (JSQ) von Roland und ein Soundsampler (für C 64) von Doepfer eingesetzt. Eine Besonderheit ist, dass der Juno 6 eine digitale Schnittstelle hatte, die aber nicht der MIDI-Norm entsprach. Mittels eines Wandlers wurden die Daten dieser Schnittstelle in MIDI verwandelt. Die von den Instrumentalisten (Geige, Gesang, Percussion) aufgenommenen Klänge wurden von dem Doepfer-Sampler live aufgenommen und verändert abgespielt. Was heute - 2020 - als relativ harmlos erscheint, war Ende der 1980er Jahre noch Ergebnis einer vertütelten Konstruktion: die Firma Doepfer, heute gut im Geschäft mit modularen Analogmoduln, stand gerade in ihren Anfängen und bastelte ad hoc kleine Plantinen für den Commodore.

DDas musikalische Ziel der Gruppe "New Fusion" war zu erproben und vor einem Publikum konzertreif vorzuführen, dass sich ein Computer wie ein akustisches Musikinstrument behandeln lässt und eben auf diesem "Instrument" auch improvisiert werden kann.

Projekt 6: Brain & Body

"Brain and Body" ist ein Projekt zur Erforschung der Mensch-Maschine-Interaktion. Live-Elektronische Improvisation mit Computern verbunden mit Gesang, Geigenspiel und Steptanz. Das Video demonstriert an einem Ausschnitt aus einem Konzert 1989, wie die beiden Künstler Peter Bayreuther und Wolfgang Martin Stroh interagieren. Neben verschiedenen Effektgeräten, die den Geigen-Sound modulieren, wird der Gesang auch im Computer (hier einem Atari ST) verarbeitet. Auf Seiten der Elektronik kommen neben dem geeignet vorprogrammierten Atari ST zwei Keyboard-Synthis zum Einsatz, wo bei das eine mit dem Soundsampler S 330 von Roland verbunden ist. Da dies Video vor allem die Spezifika der Interaktion der beiden Musiker demonstrieren will, kommt nicht der gesamte "Gerätepark" von Brain and Body zum Einsatz. Den kann man in den Videos 8 bis 11 der Playlist bewundern und hören...

"Brain and Body" hat 38 Konzerte gegeben. Neben dem genannten eher "wissenschaftlichen" Ziel des Projekts ging es den Musikern auch darum zu zeigen, dass und wie sich Avantgarde und Popmusik, E und U miteinander verbinden lassen. Den Schlüssel hierzu sahen beide Musiker darin, der Musik über weite Strecken einen Groove zu verpassen und die "abgehobenen" Passagen immer wieder in tanzbare Musik einzufangen. Da in den 1980er Jahren sich die Schere zwischen "EDM" (Elektronischer Tanzmusik) und "EM" (Elektroakustischer Musik) immer mehr zu öffnen begann, war "Brain and Body" der Versuch, zwischen diesen Extremen zu vermitteln.

Mehr Info auf https://www.musik-for.uni-oldenburg.de/brainandbody.

Projekt 7: Das Oldenburger TechnoMuseum

Das Oldenburger "TechnoMuseum" besteht aus 10 Analogsynthesizern ( 2 Korg MS20, 2 Korg MS50, 3 SynthiA von EMS, 1 Roland Mono/Poly, 1 Arp Odysse, 1 Juno 106 von Roland), die von 12 Musikern live gespielt werden können. Ein Computer (genauer: das 10-stimmige Pattern eines Sequenzerprogramms) spielt allen analogen Instrumenten einen "komponierten" Groove in Form von "Clock-Impulsen" zu. (Die Verwandlung von MIDI-Daten in Clock-Impulse leistet das 24-kanaliges Gerät MCV 24 von Doepfer). Dadurch können die Musiker mit den analogen Geräten eigene ("freie") Klänge mit einem gemeinsamen Groove erzeugen. Das Sequenzerprogramm des Computers wird von einer GrooveBox gesteuert, die selbst nach Bedarf angesagte Percussionsklänge und Bass-Läufe beisteuern kann. In dem Sequenzerprogramm befindet sich auch noch eine Midispur zur Steuerung einer midifizierten Stroboskopanlage (eine Eigenkonstruktion des Instituts für Musik Oldenburg). Das Projekt hat zwischen 1997 bis 2003 zahlreiche "Parties" gestaltet. Da sich aber kein längerfristiger Aufenthaltsraum für die wertvollen Instrumente finden ließ, wurde das Projekt wieder eingestellt. Heute (2020) kann man die meisten "Bruchstücke" im Medienbereich der Oldenburger Uiversitätsbibliothek bewundern und gegebenenfalls spielen.

Musikalisches Ziel des Projekts war zu zeigen, dass und wie analoge Synthesizer quasi als Orchester zusammen spielen können, ohne das das Gesamtergebnis ein undurchdringbarer Klangmulm sondern eine klar strukturierte, tanzbare Party-Musik ist. Weitere Info: https://www.musik-for.uni-oldenburg.de/techno

Weitere Bilder, Audios und Erklärungen zum Technomuseum hier!

Projekt 8: Das MIDI-Planetarium

Das MIDI-Planetarium ist ein 1991 von Wolfgang Martin Stroh entwickeltes Tool (Computerprogramm) zur musikalischen Darstellung von Sternenkonstellationen. Wie in einem (optischen) Planetarium scannt das Programm den Sternenhimmel und transformiert die Positionen der Gestirne in Töne. Konkret erzeugt das Programm eine musikalisch geordnete Abfolge von MIDI-Daten, die von einem Musiker live in Klänge umgesetzt werden können. Ist der Zeitpunkt und Ort des Geschehens (dies kann Zeitpunkt und Ort eines Konzerts oder eines besonderen Events wie der Geburt eines Menschen [="Geburtshoroskop"] sein) fest gelegt, so steht die Abfolge der MIDI-Daten fest und läuft deterministisch ab. Bei der Gestaltung der Klänge jedoch hat der Musiker freie Wahl und kann die Musik spontan zum Beispiel in Improvisationen anderer Musik einbetten. Der Umsetzung der Stern-Positionen in Töne liegt die holistische Theorie der "Harmonie der Welt" von Pythagoras, Johannes Kepler und Hans Cousto zugrunde. Danach können periodische Vorgänge im Kosmos (also vor allem reale oder scheinbare Bewegungen von Sternen) durch "Oktavierung" in Bereiche der erlebbaren Rhythmen, der hrbaren Tonfrequenzen oder der sichtbaren Lichtfrequenzen überführt werden. Bezogen auf unser Planetensystem kann damit jedem Planeten ein Rhythmus, eine Tonhöhe und eine monochörome Farbe zugeordnet werden (= Theorie der "Planetentöne" nach Hans Cousto). Das Programm "MIDI-Planetarium" bewegt sich vorzugsweise durch die Ekliptik, kommt an den einschlägigen Gestirnen vorbei und "spielt" deren Töne und Rhythmen. In jedem Augenblick eines Spielvorganges wird die Entfernung zu allen Gestirnen gemessen und als Oberton des entsprechenden Grundtons des Gestirns ausgedrückt. Dadurch ergibt sich ein komplexes Spiel von Obertönen aller Grundtöne der auf der Ekliptik befindlichen Gestirne. In jedem Augenblick des Programmablaufs ist auf diese Weise ein "Bild" der gesamten Sternenkonstellation präsent, auch wenn dies vom hrer nicht "durchschaut" werden kann. In der inzwischen 29-jährigen Praxis (mit über 60 Kompositionsaufträgen und 32 Konzerten ) haben sich drei besonders prägnante Settings entwickelt: (1) "Geburtshoroskop": verwendet werden die Gestirne entlang der Ekliptik und deren Position von der Erde aus betrachtet zum Zeitpunkt und vom Ort aus der Geburt eines Menschen. Hierzu wurde ein breit angelegtes Forschungsprojekt durchgeführt. (2) Das "Konzertante MIDI-Planetarium": verwendet werden die Gestirne entlang der Ekliptik und deren Position von der Erde aus betrachtet zum Zeitpunkt und vom Ort aus eines Konzertes, bei dem neben den elektronisch erzeugten Klängen auch Musiker mit akustischen Instrumenten (z.B. ein Obertonmusiker) mitwirken. (3) "Ambient Music": das MIDI-Planetarium bespielt im Sinne von ambient music einen Raum aufgrund von Daten, die eine Bedeutung für diesen Raum haben. Im vorliegenden Video: zunächst der Sonnenton nach Cousto, sodann der Mitschnitt aus einer Aufführung über und unter Wasser in Bad Sulza im Sinne der "Ambient Music". Auf dem folgenden Video 13 der Playlist sieht man einen Mitschnitt des Konzerts eines "Konzertanten MIDI-Planetariums".

Ablauf im vorliegenden Video:

Ausführliche Information zum Projekt unter https://www.musik-for.uni-oldenburg.de/planet.

Ein weiteres Video zum MIDI-Planetarium !

Projekt 9: Microtuning und "Bagdad 1991"

Das Musikstück "Bagdad 1991" ist anlässlich des Einmarsches der US-Truppen im Irak am 17.1.1991 entstanden. Es zieht eine Parallel zwischen dem Strahlentodtango der Anti-AKW-Bewegung und den Äußerungen von Soldaten anlässlich dieses Einmarsches. Zum Schluss wird eine Parallele zwischen diesem US-Einmarsch und dem aktuellen Wüten des Islamischen Staates gezogen. Musikalisch wird zwischen dem temperierten System einen einem persischen Datstagha gewechselt.

Weitere elektronische Musik-Video sind unter "Playlist Elektronische Musik made in Oldenburg" zu finden.

Unter anderem auch e-Beat (hier weitere e-Beats)

Nachtrag: GMD und die "Experimentelle Musik"

GMD steht für Gertrud Meyer-Denkmann (1918-2014), eine herausragende experimentelle Musikern, die hier einem Flügel live-elektronische Klänge entlockt. Mitschnitt einer Show der Oldenburger Medienmusikpraxis 2005 mit der 87-jährigen Künstlerin. Das Konzept ist stark von John Cage und dessen "Medienkompositionen" sowie den Ideen zum präparierten Klavier beeinflusst. Als "elektroakustische Musik" würde aber solch eine Performance heute kaum mehr durchgehen, weil die akustischen Klänge "nur" elektronisch verfremdet werden, hinter dieser Klangverarbeitung aber kein (kompositorisches) Konzept zu erkennen ist. Das vorliegende Video als Hommage a GMD könnte jedoch durchaus als "elektroakustische Musik" durchgehen, weil in ihm Videoclips verschiedener Aktionen an einem Tag der Offenen Tür zur Medienkunst miteinander akustisch und visuell verbunden, mit assoziativen Samples klassischer Klaviermusik unterlegt und letztendlich auf die Performance von GMD bezogen worden sind.